![[HR 수다] 팔란티어의 비밀병기 FDE와 데이터기반 문제해결!](https://cdn.offpiste.ai/images/articles/849/cover/b00dea7b-0877-49ee-84ad-0c3381a2178d_On-the-Shoulder-of-a-Giant-feature-650x300.jpg)

[HR 수다] 팔란티어의 비밀병기 FDE와 데이터기반 문제해결!

데이터분석가들의 송년회

한 해를 떠나 보내는 분주한 발 길이 이어지는 나날입니다. 사실 저는 직장생활도 사회생활도 별다른 분주함 없이 고만고만하게 하는 스타일이라 스마트폰 일정표는 늘 비어있는 편입니다. 그래도 다행히 찾아 주는 분들이 드문드문 있어서 사회에서 만나 가깝게 지내는 분들의 초대를 받아 어느 밤 저녁을 함께 했습니다. 한 분은 대전에 본거지(?)를 둔 유명한 데이터분석가이시고 다른 한 분은 남양주에 본부(?)를 두고 활동하시는 유명한 엑셀전문가이십니다. (누군지 한번 맞춰보세요~ ㅎㅎ)

늦은 밤 어느 유명하다는 용산역 인근 장어구이집에서 만났습니다. 술잔을 기울이며 나눴던 이야기의 대부분이 4050의 주제들이었습니다. 하지만 늘 하는 일이 일인지라 결국 대화는 자연스럽게 데이터분석으로 흘러갔습니다.

“앞으로 AI는 데이터분석이라는 일을 어떻게 바꿔나갈 것인지?”

“데이터분석가라는 일은 살아남을 것인지?”

“지금 데이터분석가들은 무엇을 준비해야 하는것인지?”

대충 이런 이야기를 하다보니 자연스럽게 팔란티어(Palantir) 이야기가 나왔습니다. 팔란티어는 현재 제가 몸담고 있는 회사와 전략적 파트너십을 맺고 함께 일하고 있는 회사라 더욱 관심을 두고 있습니다. “팔란티어가 가진 차별화 포인트는 무엇인지?”, “팔란티어 플랫폼은 어떤 구조인지?” 여러가지 많은 주제가 테이블 위에 펼쳐졌지만 그 중에서도 유독 팔란티어에서 고객사에 파견하는 엔지니어(Forward Deployed Engineers, FDE)에 대해서 나눴던 이야기가 기억납니다. 이들은 고객사에 파견되어 일을 하는 팔란티어의 정예인력입니다. 고객사 내부로 들어가서 직무전문가들과 함께 워크숍을 운영하면서 고객사의 문제를 파악하고 정의하는 작업에 집중합니다. 고객사 직무전문가들이 시스템과 데이터의 관점에서 문제를 정의하고 해결방안을 찾도록 돕습니다. 워크숍은 짧을 때는 몇 일이 걸리기도 하지만, 복잡하고 어려운 경우 수 개월이 걸리기도 합니다. 이들은 매우 독특한 존재들이고 팔란티어에서 공들여 육성하는 핵심자원입니다. 왜 그럴까요?

목격한 현상 vs. 정의된 문제

팔란티어가 FDE를 중요한 자산으로 육성하고 관리하는 이유는 이들이 고객사와 협력하여 고객사에서 문제라고 착각하고 있는 관찰된 현상을 해결할 수 있는 문제로 제대로 정의하는 작업을 하기 때문입니다. 먼저, 고객사가 문제를 제대로 정의하도록 ‘온톨로지 레이어(Ontology Layer)’를 그리도록 돕습니다. 이어서 설계된 온톨로지 레이어의 각 ‘엔티티(Entity)’에 ‘데이터 레이어(Data Layer)’를 연결하는 작업을 합니다. 만약 ‘데이터 레이어’나 ‘온톨로지 레이어’, ‘엔티티’와 같은 용어가 낯설게 느껴지신다면 잠시 글 읽기를 멈추시고 과거 제가 작성한 글(지난 글 읽기)을 한번 읽어 보시면 이해하시는데 도움이 되실거에요.

다시 이야기로 돌아와서, FDE는 데이터엔지니어 관점에서 관찰된 현상을 문제로 바꾸어 놓는 작업을 합니다. 데이터사이언티스트 관점에서 보면 여전히 많은 구성원들이 본인이 목격한 현상과 문제를 혼동합니다. 예를 들어, ChatGPT 도입 과정에서 발생하는 문제를 정의해 보라고 하면 높은 빈도로 아래와 같이 대답하는 경우를 볼 수 있습니다.(물론, 훌륭하게 문제를 잘 정의하시는 분들도 계십니다)

“ChatGPT를 도입했는데 확산이 잘 되지 않는게 문제야!”

“ChatGPT를 도입했는데 리더들이 잘 안쓰는게 문제야!”

“ChatGPT를 도입했는데 쓰는 사람들만 쓰는게 문제야!”

“ChatGPT를 도입했는데 아이디만 부여받고 한번도 안 쓴 사람이 너무 많다는게 문제야!”

하지만, 위와 같은 진술은 데이터분석 관점에서 바라볼 때 “문제를 정의했다”라고 할 수 없습니다. “일어난 현상에 대해서 관찰한 결과를 표현했다.” 정도로 이야기할 수 있겠습니다. 그렇다면 데이터분석 관점에서 문제정의는 어떻게 해야하는 걸까요? 첫째, 현상을 면밀히 살펴보고 ‘현재의 상태(Current Status)’와 ‘이상적인 최종결과(Ideal Final Result, IFR)’를 설정해야 합니다. 출발지와 최종목적지가 있어야 길을 찾아갈 수 있거든요. 둘째, 출발지에서 최종목적지까지 가는 길에 영향을 즐 수 있는 다양한 변수들을 찾아내야 합니다. 셋째, 찾아낸 변수들의 개념을 잘 정의한 뒤 어떻게 측정(measure)할 것인지 측면에서 측정할 데이터의 종류, 데이터를 수집할 원천, 데이터의 유형, 데이터의 특성을잘 정의해야 합니다.

첫 번째 할 일인 현재의 상태와 이상적인 최종결과는 해당 업무에 대한 직무전문성이 어느 정도 있다면 어렵지 않게 정의할 수 있습니다. “ChatGPT를 도입했는데 아이디만 부여받고 한번도 안 쓴 사람이 너무 많다.”는게 현상이라면 현재의 상태는 아이디 보유자 중 사용량이 0인 사람이고, IFR은 최소사용량이 얼마 이상인 사람으로 할지 결정하면 됩니다. 즉 현재의 상태와 IFR을 측정 가능하도록 바꾸어 놓으면 됩니다. 그리고 “실제로 현재의 상태와 IFR은 무엇으로 측정(measure)할 것인지?”는 두 번째 할 일에서 결정하면 됩니다. 여기서는 프롬프트 입력 건 수(n_prompt)와 같은 데이터를 측정할 수도 있겠고, 상황에 따라서는 일 접속 횟 수(login_frequencies)와 같은 데이터를 측정할 수도 있겠네요. 다양한 데이터들 중 무엇을 측정하면 적합할지 고민하여 결정하면 됩니다.

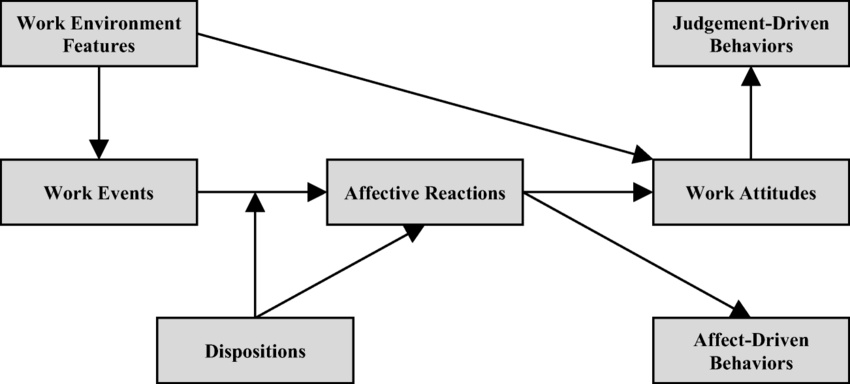

두 번째 할 일인 변수들을 찾아 내는 일은 조금 복잡합니다. 직무전문성이 더욱 빛을 발하는 작업이기도 합니다. ‘현재의 상태’에서 IFR로 가는 길에 영향을 주는 요인들을 찾는 일입니다. 일을 조금 더 쉽게 하려면 거인의 어깨에 올라서는 것을 추천드립니다. 문제의 핵심주제를 기반으로 이론적인 모델을 찾는 방법입니다. ChatGPT를 도입한 결과에 대한 주제는 Information System(IS)을 조직에 도입한 주제로 추상화할 수 있습니다. 그러면 IS 도입에 따른 수용(Post-Adoption)이라는 주제로 바뀌게 됩니다. 이를 기반으로 학술적 지식기반(Academic Knowledge Base)인 논문을 뒤져보면 됩니다.

과거에는 이러한 과정이 석사나 박사들과 같이 학술적으로 훈련된 사람이 아니면 접근하기 쉽지 않았습니다. 하지만 이제는 생성형 AI의 출현으로 장벽이 확 낮아졌습니다. 생성형 AI에게 현재의 상태와 IFR을 제공하고 관련된 연구모델과 논문을 찾아달라고 하면 됩니다. 가급적이면 해당 분야의 상위저널(Top Journal)이 무엇인지 먼저 물어보시고, 그 저널들 중에서 찾아달라고 하는 것이 좋습니다. 이렇게 생성형 AI를 통해 찾은 논문은 대부분 영어논문입니다. 하지만 이젠 언어와 무관하게 Notebook LM과 같은 훌륭한 RAG 기반 A